最小二乗法の復習

個のデータ

が与えられています。

で、

と表します。

線形回帰モデルは以下のよう表されるとします。

ただし、です。

また、を以下のようにおきます。

この時、目的関数を以下のように定義します。

目的関数を最小化したを

と表すと

となります。

最小二乗解の幾何学的解釈

を以下のようにおきます。

(1)と(4)をまとめて書きます。

(4)を(6)に代入します。

ここで、を

の

番目の列ベクトルとします。

の部分空間

は

で張られています。

PRML演習問題 3.2(標準) より、を部分空間

へ直交射影したものが

ということになります。

に対する最小二乗解は、部分空間

内にあり

に最も近い

を選ぶことに相当します。

イメージ図を以下に記します。

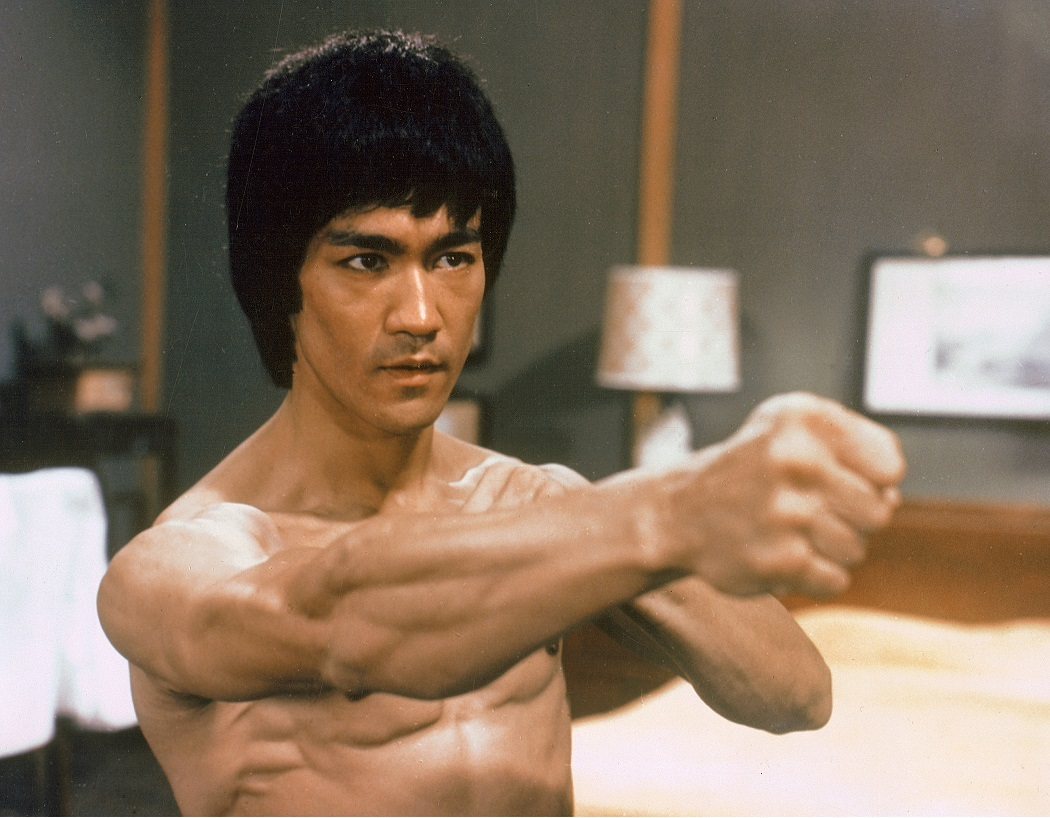

偉人の名言

目標は必ずしも達成されるためにあるのではない。

目指すべき何かを与えてくれることも多い。

ブルース・リー